ผู้ใช้ Facebook และ Instagram จะสามารถพูดคุยกับเสียงที่คล้ายกับ John Cena และ Judi Dench ได้ แต่พวกเขาไม่ใช่นักแสดงตัวจริง แต่เป็นเสียงของแชทบอทที่ใช้ปัญญาประดิษฐ์

บริษัทแม่ Meta (META) ประกาศเมื่อวันพุธว่า ได้เพิ่มการสนทนาด้วยเสียงและเสียงของคนดังให้กับแชทบอทปัญญาประดิษฐ์ Meta AI ซึ่งตอนนี้ผู้ใช้จะสามารถสนทนาแบบเรียลไทม์แทนการส่งข้อความอย่างเดียว และยังสามารถเลือกเสียงที่สร้างจากคอมพิวเตอร์หรือเสียงของคนดังได้

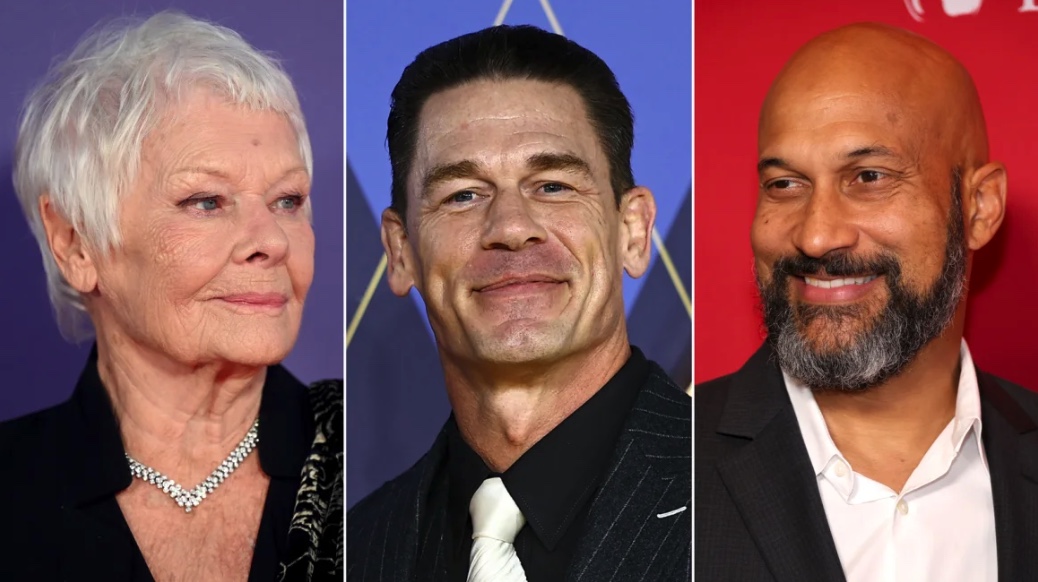

บริษัทได้ร่วมมือกับ Cena และ Dench รวมถึงนักแสดง Kristen Bell, Awkwafina และ Keegan-Michael Key เพื่อฝึกฝนให้แชทบอทเลียนแบบเสียงของพวกเขา

การอัปเดตนี้เกิดขึ้นในขณะที่ Meta พยายามพัฒนาแชทบอท AI ของตน — ซึ่งผู้ใช้สามารถแชทผ่าน Facebook, Instagram, WhatsApp และ Threads — ให้ทันกับผลิตภัณฑ์ของคู่แข่ง เช่น ChatGPT ซึ่งกำลังเปิดตัวโหมดเสียงขั้นสูงของตนเอง Mark Zuckerberg ซีอีโอของ Meta กล่าวว่า Meta AI กำลังพัฒนาอย่างต่อเนื่องและจะกลายเป็น “ผู้ช่วย AI ที่มีคนใช้มากที่สุดในโลก” ภายในสิ้นปีนี้ ซึ่งเป็นไปได้ด้วยจำนวนผู้ใช้งานแอปของบริษัทกว่า 3 พันล้านคนต่อวัน แม้ว่าไม่ชัดเจนว่า Meta วัดการใช้งานของแชทบอทอย่างไรและผู้คนมีส่วนร่วมกับเครื่องมือนี้บ่อยแค่ไหน

OpenAI คู่แข่งของ Meta เคยถูกวิพากษ์วิจารณ์เมื่อต้นปีนี้เมื่อแสดงโหมดเสียงแบบเรียลไทม์ใน ChatGPT เนื่องจากเสียงเดโมฟังดูคล้ายกับนักแสดง Scarlett Johansson อย่างมาก Johansson กล่าวว่าเธอถูกเชิญให้เข้าร่วมโครงการแต่ปฏิเสธ OpenAI ปฏิเสธว่าเสียงที่ตั้งชื่อว่า Sky นั้นไม่ได้อิงจาก Johansson แต่ก็หยุดการใช้งานเสียงนั้นชั่วคราว อย่างไรก็ตาม Meta ดูเหมือนจะจัดการความร่วมมืออย่างเป็นทางการกับนักแสดงที่ใช้เสียงฝึกฝนเครื่องมือของตน

Zuckerberg ประกาศโหมดเสียงใหม่ในระหว่างการกล่าวสุนทรพจน์ที่งาน Meta Connect ประจำปีของบริษัท ซึ่งเขายังได้เปิดเผยความก้าวหน้าอื่น ๆ เกี่ยวกับ AI รวมถึงเวอร์ชันใหม่ของ Meta Quest ที่ราคาถูกลง และการอัปเดตแว่นตา Ray-Ban ที่ใช้เทคโนโลยีเสริมความเป็นจริง (AR)

ในประกาศอื่น ๆ ที่น่าสนใจ Meta จะอนุญาตให้ผู้มีอิทธิพลในโซเชียลมีเดียสร้าง AI ที่เลียนแบบตัวเองได้ โดยก่อนหน้านี้ ผู้มีอิทธิพลสามารถฝึกฝน AI ให้สนทนากับผู้ติดตามผ่านข้อความได้ ตอนนี้ผู้ติดตามจะสามารถสนทนาในรูปแบบกึ่งวิดีโอคอลกับ AI ที่เลียนแบบตัวตนของผู้มีอิทธิพลที่ใช้เครื่องมือนี้

เทคโนโลยี AI ของ Meta ยังจะสามารถแปลและพากย์วิดีโอ Reels (วิดีโอสั้นของ Meta) เป็นภาษาต่างประเทศได้โดยอัตโนมัติ ตัวอย่างเช่น หากคุณพูดภาษาอังกฤษแต่เห็น Reel ที่สร้างในภาษาสเปน มันจะปรากฏในฟีดของคุณเหมือนกับว่าถูกสร้างเป็นภาษาอังกฤษ รวมถึงการแก้ไขการขยับปากให้เข้ากับการพากย์เพื่อให้ดูเป็นธรรมชาติ

นอกจากนี้ คุณอาจเริ่มเห็นเนื้อหาที่สร้างโดย AI มากขึ้นในฟีด Facebook และ Instagram ของคุณ Meta กล่าวว่าจะเริ่มสร้างและแชร์ภาพที่สร้างโดย AI ตาม “ความสนใจหรือแนวโน้มปัจจุบัน” ของผู้ใช้ ซึ่งฟีเจอร์นี้เรียกว่า “imagined for you” (ยังไม่ชัดเจนว่าผู้ใช้สามารถเลือกไม่ใช้ฟีเจอร์นี้ได้หรือไม่ หากพวกเขาต้องการเห็นเฉพาะเนื้อหาจากเพื่อนจริง ๆ เท่านั้น)

แว่นตา AR ของ Meta ก็จะมีการแปลแบบเรียลไทม์โดยใช้ AI ด้วย ผู้ใช้สามารถสนทนากับคนที่พูดภาษาต่างประเทศได้ และภายในไม่กี่วินาทีจะได้ยินการแปลเป็นภาษาของตนเองในหูของตน Zuckerberg กล่าว

Zuckerberg ยังได้แสดงตัวอย่าง “Orion” ซึ่งเป็นต้นแบบของแว่นตาที่มีเทคโนโลยีขั้นสูงซึ่งจะรวมความสามารถของชุดหูฟัง AR — เช่น Meta Quest หรือ Vision Pro ของ Apple — ไว้ในแว่นตาที่ดูเป็นปกติ (แม้จะดูหนาไปบ้าง)

แต่มีความแตกต่างใหญ่ระหว่าง Orion กับชุดหูฟังอย่าง Quest หรือ Vision Pro สำหรับชุดหูฟัง AR ที่มีอยู่ในปัจจุบัน ผู้ใช้จะมองผ่านหน้าจอที่ใช้กล้องเพื่อแสดงอีเมลหรือรูปภาพที่ซ้อนทับกับสภาพแวดล้อมของผู้ใช้ ซึ่งเป็นเทคโนโลยีที่เรียกว่า “passthrough” แต่เลนส์ของ Orion นั้นเป็นเลนส์ใสและใช้ภาพโฮโลแกรมในการแสดงผล เช่น ทำให้ดูเหมือนว่ากล่องข้อความอีเมลของคุณหรือข้อความ หรือแม้แต่ภาพจำลอง 3 มิติของเพื่อนกำลังลอยอยู่ข้าง ๆ คุณ

Zuckerberg กล่าวว่าแว่นตานี้เป็น “แว่นตาที่ล้ำหน้าที่สุดในโลกเท่าที่เคยมีมา” แต่ยังไม่พร้อมสำหรับการวางจำหน่ายให้กับผู้บริโภค ซีอีโอกล่าวว่า Meta จะยังคงทดลองใช้แว่นตานี้ภายในบริษัทและทำให้พร้อมสำหรับนักพัฒนาภายนอกที่เลือกมาพัฒนาโปรแกรมสำหรับแว่นตาก่อนที่จะมีเวอร์ชันสำหรับผู้บริโภคในอนาคต

Meta is bringing the voices of Judi Dench, John Cena and Keegan-Michael Key to its AI chatbot

Facebook and Instagram users will now be able to talk to voices that sound a lot like John Cena and Judi Dench. They won’t be the real actors, though, but an artificial intelligence chatbot.

Parent company Meta (META) announced Wednesday that it is adding voice conversations and celebrity voices to its artificial intelligence chatbot, Meta AI. Now, instead of simply messaging with the chatbot, users can have real-time conversations and can choose from a selection of computer-generated or celebrity voices.

The company partnered with Cena and Dench, as well as actors Kristen Bell, Awkwafina and Keegan-Michael Key, to train the chatbot to replicate their voices.

The update comes as Meta seeks to help its AI chatbot — which users can chat with on Facebook, Instagram, WhatsApp and Threads — keep pace with competitors’ products, including ChatGPT, which is rolling out its own advanced voice mode. Meta CEO Mark Zuckerberg said Meta AI is on track to be “the most used AI assistant in the world” by the end of this year, likely helped by the more than 3 billion people who use the company’s apps each day, although it’s not clear how Meta is measuring use of the chatbot and how frequently people engage with the tool.

Rival OpenAI came under fire earlier this year when it showed off its own real-time voice mode feature for ChatGPT because of a demo voice that sounded remarkably like actor Scarlett Johansson, who said she had been asked to participate in the project but declined. OpenAI denied that the voice, dubbed Sky, was based on Johansson, but paused its use anyway. Unlike that debacle, Meta appears to have formed formal partnerships with the actors whose voices were used to train its tool.

Zuckerberg announced the new voice mode during his keynote speech at the company’s annual Meta Connect conference, where he also shared other AI advancements, a new, cheaper version of Meta’s Quest headsets and updates to the company’s line of augmented reality RayBan glasses.

Among the other notable announcements: Meta will now let social media influencers make AI versions of themselves. Previously, influencers could train AI to have text conversations with their followers; now, followers will be able to have full, quasi-video calls with the AI versions of influencers who use the tool.

Meta’s AI technology will also auto-translate and dub foreign language Reels (Meta’s short-form videos) for viewers. So, if you speak English but a Reel comes across your feed that was originally created in, say, Spanish, it will appear in your feed as if it were made in English, complete with edits to the speaker’s mouth to make the dubbing look natural.

And you might start seeing more AI-generated content in your Facebook and Instagram feeds. Meta says it will start to generate and share AI-generated images to users’ feeds based on their “interests or current trends,” a feature it’s calling “imagined for you.” (It’s not clear whether users will be able to opt out of this if they’d prefer to see only content from their real, human friends.)

Meta’s AR glasses are getting live, AI-enabled translation, too. A user can have a conversation with someone speaking in a foreign language and, within seconds, hear the translation to their own language in their ear, Zuckerberg said.

Zuckerberg also previewed “Orion,” a prototype for a more advanced pair of techy glasses that would essentially put the power of an AR headset — like Meta Quest or Apple’s Vision Pro — into a pair of mostly normal-looking (if a bit bulky) glasses.

But there’s a big difference between the Orion and headsets like the Quest or Vision Pro. With existing AR headsets, users are looking at a screen that uses a camera to display emails or photos superimposed on the users’ surroundings, a technology known as “passthrough.” But the Orion lenses are actually see-through and use holograms to make it look as though your email inbox or text messages or even a live, 3D rendering of a friend are floating in space next to you.

Zuckerberg called them “the most advanced glasses the world has ever seen,” but they aren’t available for consumers to purchase just yet. The chief executive said Meta will continue to experiment on the glasses internally and make them available to select third-party developers to build software for them ahead of an eventual consumer version.

By Clare Duffy, CNN